Desde hace varios años tengo implementado un sistema de backup automático para mis datos importantes. Pero hechos recientes me han empujado a revisar mi estrategia, encontrando dos puntos a tener muy en cuenta:

- Mi sistema de backup tenía importantes carencias

- Mis necesidades actuales han cambiado

Nuevos tiempos requieren nuevos planteamientos, así que aproveché la caída de uno de los discos del NAS para rediseñar e implementar un nuevo sistema de backup de datos.

Como consejo para cualquiera que esté buscando una mejor manera de salvaguardar sus datos, diré que es fundamental elaborar una lista personal de necesidades, ya que las soluciones van a depender de ellas. Éstas son las mías:

- Tiene que ser automático. Ya tengo bastantes preocupaciones en mi cabeza como para sumar una mas. Si tengo que acordarme de conectar un disco duro externo cada cierto tiempo para volcar mis datos, no lo haré nunca.

- Tiene que estar redundado. No quiero tener una sola copia, quiero al menos dos en diferentes lugares. Las probabilidades de que, llegado el momento de necesidad, acceda a la primera copia y haya algún problema son altas. Suelo estar gafado en esto.

- Me tiene que proteger de desastres físicos como sobretensión, robo, incendio, o inundación. Por lo tanto, es fundamental tener una copia fuera de casa, en lugar remoto.

- Me tiene que proteger de malware/ransomware, así como de corrupciones esporádicas de datos debido a bugs en las aplicaciones que manejan los archivos.

- Me tiene que proteger de mis propias torpezas. Puedo llegar a borrar o alterar un archivo de forma accidental y sin darme cuenta. Es más, no tengo por qué descubrir el problema al momento, pueden pasar semanas o meses hasta que vea que ha pasado algo, cuando quiera volver a abrir un archivo y vea que no existe o está corrupto.

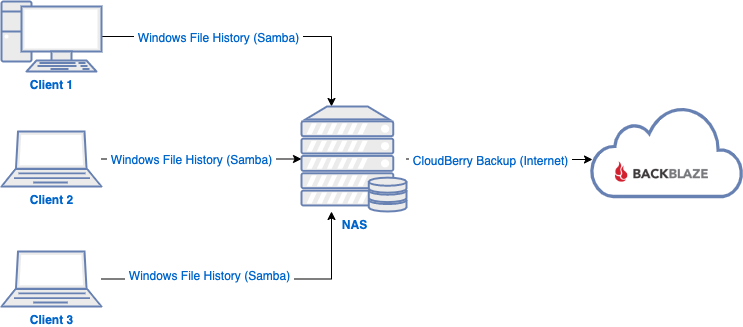

Solución Antigua: Centralizada, basada en Historial de Archivos de Windows + CloudBerry Backup

En mi ecosistema, las máquinas que contienen datos susceptibles de necesitar copia de seguridad son todas Windows 10. En el pasado tuve muy buenas experiencias con Time Machine de OS X, así que en su momento diseñé la solución confiando en que el intento de clon de Microsoft, su Historial de Archivos, sería igual de bueno. La solución que describiré ahora es la que he estado usando durante unos 3 ó 4 años, y que sólo hace unas pocas semanas descubrí cuán equivocado estaba con ella.

La solución

Se trataba de una solución centralizada en el NAS, y con una segunda copia de seguridad en un servicio de almacenamiento remoto.

¿Por qué centralizada en el NAS? Por aquel entonces mi conexión a Internet era asimétrica con unos 5 Mbps de subida, por lo que no quería tener que dejar los clientes encendidos a la espera de que completaran la copia de seguridad al almacenamiento remoto. Volcar una tarjeta de 20 GB con fotos podía suponer una carga de 9 horas al almacenamiento remoto, por lo que mi estrategia era que los clientes hicieran una copia local al NAS, mucho más rápida, y sería el NAS quien se encargue de forma centralizada de agrupar las copias de todas las máquinas y subirlas al almacenamiento remoto.

Cada cliente hacía una copia con Historial de Archivos a un recurso compartido en el NAS por Samba, y más tarde el NAS sincronizaría la copia de forma centralizada con BackBlaze B2 usando CloudBerry Backup para Linux. Todo sonaba bien.

Los problemas

Sin embargo, recientemente he descubierto que Historial de Archivos no es fiable y tiene múltiples carencias. Para mi caso de uso, éstas son las más importantes:

- Fallos silenciosos: no avisa de ninguna manera de que la copia ha ido mal, y desde la propia herramienta se indica la copia como completa aunque hayan ocurrido errores. Hay que mirar a mano en el Visor de Sucesos, mensaje por mensaje.

- No copia archivos que incluyan ciertos caracteres, que sí son admitidos por el filesystem de Windows.

- No copia archivos con rutas que superen los 255 caracteres en destino, y como añade timestamp a los nombres de archivo, aumenta el riesgo. El timestamp añade la nada despreciable cifra de 26 caracteres al nombre de archivo.

- No hay forma de que reintente los archivos fallidos: re-run, disable/enable, reconfigure no funcionan. Una vez que un archivo falla, no lo vuelve a intentar nunca más.

- La única manera de reintentar es destruir toda la copia y hacerla de cero, tardando horas, dejando los datos desprotegidos todo ese tiempo, y causando duplicados en el almacenamiento remoto debido al timestamp en los nombres de archivo.

- No hace un almacenamiento inteligente de versiones: las opciones se limitan a retener todas las copias en los últimos X meses, pero sin tener opción a disponer de mayor granularidad para los días más cercanos, o conservar una copia al mes para los últimos meses o años.

En mi caso concreto, descubrí que faltaban en torno a 12.000 archivos en mi copia de seguridad, estando afectadas todas las fotografías tomadas entre los años 2010 y 2014, entre otras cosas, y que nunca habían tenido realmente copia de seguridad. Si hubiera ocurrido un fallo en mi almacenamiento principal, hubiera perdido 5 años de fotografías.

Conclusiones

Al descubrir estos problemas, especialmente que había estado sufriendo durante años una sensación de falsa seguridad al pensar que tenía copia de ciertos archivos que realmente no tenían copia, concluí lo siguiente:

- Debo verificar las copias de seguridad de una manera más exhaustiva. No sólo debo comprobar que la copia se pueda restaurar, también debo comparar el contenido de la copia contra el origen para verificar que los datos son correctos. Al menos debería comprobar nombres de archivo, tamaños, y cierta verificación inteligente en las fechas de modificación. Idealmente también podría calcular hashes del contenido y comparar dichos hashes para verificar que no existe corrupción de datos.

- Debo diseñar una nueva solución técnica de copias de seguridad, adaptada a mis necesidades actuales y con herramientas más fiables.

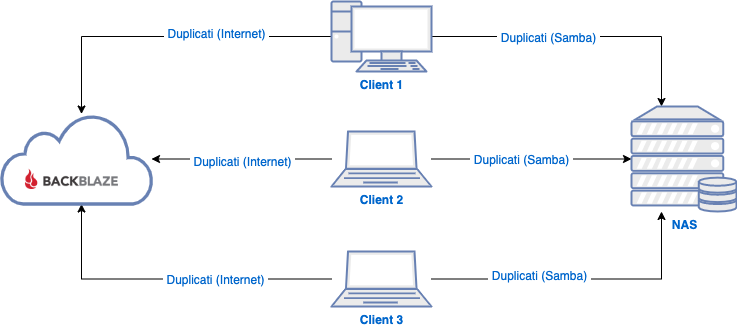

Solución Nueva: Descentralizada, basada en Duplicati

Uno de los problemas de la solución anterior es que todo se basaba en una herramienta fallida: Historial de Archivos de Windows. Necesitaba otras herramientas. Una primera aproximación era pasar a utilizar CloudBerry Backup directamente en los clientes. Sin embargo, debido al coste de licencias ($50 por máquina) descarté esta opción, ya que no es lo mismo pagar una única licencia para el NAS y centralizarlo todo ahí, que pagar N licencias, una para cada cliente.

Otro de los problemas es que, al ser una solución centralizada, el NAS se convierte en punto único de fallo (single point of failure). Si el NAS cae, tanto la copia del NAS como la copia remota dejarían de funcionar. Toda la solución se basa en que una máquina concreta funcione correctamente todo el tiempo. Pensé que sería conveniente evitar eso.

La solución

Actualmente dispongo de una conexión de fibra simétrica con 600 Mbps de subida, por lo que la necesidad inicial de centralizar las copias en el NAS desaparece. Ahora mismo, volcar una tarjeta con 20 GB de fotos suponen unos 5 minutos de tiempo de carga al almacenamiento remoto, frente a las 9 horas que necesitaba hace unos pocos años. Es perfectamente asumible que ahora sean los propios clientes los encargados de sincronizarse con el almacenamiento remoto directamente, liberando al NAS de hacer esta tarea.

Esto además tiene otro importante beneficio, y es que cada cliente mantendrá dos copias de seguridad independientes. Si una de ellas se vuelve corrupta por la razón que sea, la otra no tiene por qué estarlo también. En el antiguo esquema, si la copia del NAS se volvía corrupta, lo que se subía al almacenamiento remoto también lo iba a estar, ya que era una «copia de la copia».

Sobre el software, tras investigar diversas herramientas que soportaran tanto copias por red como copias a servicios de almacenamiento remoto como Amazon S3 o BackBlaze B2, y que tuvieran un coste asumible, me decanté por Duplicati.

Duplicati es un proyecto GNU/GPL y multiplataforma, que proporciona una solución de copias de seguridad fiable, robusta, con soporte para múltiples destinos, incluyendo los servicios de terceros más populares. Encontré muy buenas referencias de él, hay mucha gente contribuyendo, y no vi grandes bugs en el historias de cambios del proyecto en GitHub. Por ello, decidí darle una oportunidad.

He instalado Duplicati en cada cliente, definiendo dos copias de seguridad:

- Una copia diaria al NAS por Samba, con almacenamiento inteligente de versiones. Cada cliente copia a un directorio diferente.

- Una copia diaria a BackBlaze B2, con almacenamiento inteligente de versiones. Cada cliente copia a un bucket diferente.

Conclusiones

Llevo unas semanas, y hasta la fecha mis impresiones son muy positivas. Las copias se completan con bastante velocidad, tengo dos destinos independientes, y por lo que he podido comprobar, esta vez sí que están todos mis archivos importantes incluidos en la copia. Además, cuando ocurre un problema, se visualiza una notificación en el cliente, aunque hubiera estado bien poder configurar un email donde recibir y centralizar tanto notificaciones de copia completada como de copia fallida. Quizá podría contribuir al proyecto creando esa funcionalidad.

Siguientes pasos

Lo más importante es asegurarme de que las copias de seguridad siguen siendo fiables con el paso del tiempo. Por ello, debo diseñar un sistema de comprobación del contenido de todas las copias, tanto del NAS como del almacenamiento remoto, y no solo debe comprobar que la copia sea restaurable, sino que estén todos los datos, y que estos sean correctos. Y por supuesto, tiene que hacerse de forma automática. Si no me puedo fiar de mí mismo para hacer una copia de seguridad manual de forma regular, tampoco puedo fiarme de que vaya a estar comprobando las copias cada mes. Quizá lo haga el primero, pero os aseguro que después me olvidaré.

El sistema de comprobación debe:

- Restaurar los datos automáticamente desde cada origen: NAS y B2.

- Comprobar que todos los archivos del origen se encuentran en la copia.

- Comprobar que los tamaños y fechas de archivo entre el origen y la copia se corresponden.

- Enviar una notificación por email cuando la verificación sea correcta.

- Enviar una notificación por email cuando haya ocurrido un problema de verificación junto con un informe que contenga el detalle, enumerando cada archivo con problemas y el error detectado.

- Ejecutarse de forma automática y periódica, inicialmente una vez al mes.

Conclusiones finales

Si hay algo peor en informática que la falta de seguridad, es la falsa seguridad. La falsa seguridad es cuando igualmente no estás seguro pero ni siquiera lo sabes, y por lo tanto asumes riesgos que de otra manera no hubieras asumido. En mi caso estaba tranquilo y confiaba en mi sistema de copias de seguridad, cuando en realidad hubiera perdido muchos datos únicos en caso de catástrofe.

Afortunadamente no lo he llegado a sufrir, lo he detectado a tiempo (de casualidad, dicho sea), y he podido ponerle remedio. Pero otros podrían no correr la misma suerte que yo.

Las necesidades cambian con el tiempo, y la fiabilidad de las soluciones también. Revisa tus estrategias de vez en cuando, comprueba que tus soluciones sigan siendo buenas y cubran tus necesidades, y cambia tus soluciones cuando no sea así. Lo que ayer valía, hoy puede que no lo haga. El cambio es la única constante.

Hola! Interesante artículo, he llegado por casualidad a tu web desde un enlace que han dejado en el foro h2m.

Me ha resultado interesante porque me ha hecho pensar cómo tengo implmentado la gestión de backups en mi sistema y si cubre mis necesidades actualmente.

Un resumen breve de mi sistema actual:

– 1 NAS OpenMediaVault

– 1 PC Windows

– 1 Portátil MacOS

– 1 Smartphone iOS

1. NAS: es el punto de unión de todos los equipos, donde se encuentran almacenados todos los archivos (fotos, arhivos personales, etc.). Es decir, ningún equipo de la red almacena archivos importantes, todos se almacenan directamente en el NAS. Para ello monto automáticamente a través de samba en cada inicio los directorios que utilizo más amenudo.

2. Windows: es el equipo principal (arranque dual con Fedora), no tiene archivos importantes pero sí me interesa mantener una imagen del sistema.

3. MacOS: al igual que Windows, no es habitual que almacene archivos importantes en él.

4. Smartphone: no soy aficionado a la fotografía, pero las pocas fotos que hago, las hago desde el teléfono por lo que necesito realizar backups «a menudo» del teléfono.

¿Cómo y qué software utilizo para las copias de seguridad?

– UrBackup

– Duplicati

– TimeMachine

Los tres «software» se encuentran en el NAS. El primero de ellos lo utilizo como servidor de las imágenes del sistema para Windows, automatizado para que realice una imagen cada 15 días y que almacene hasta un máximo de 5 versiones. El segundo al igual que lo has configurado tú, lo utilizo para realizar un backup del NAS (archivos y backups que almacena) a Backblaze, tengo contratado el pago por uso. El tercero y último, un plugin en el NAS para poder seleccionar un directorio compartido desde el Mac como destino de las copias del TM.

Respecto al smartphone, simplemente he hecho un enlace simbólico del directorio por defecto que almacena los backups. No conozco ningún software que permita hacer backups de iOS inalámbricamente (dudo que exista).

Además del backup que realizo a Backblaze de todo el contenido del NAS, hago una copia a un disco externo, el cual tengo que conectar manualmante. Sí, es un inconveniente, porque me gustaría hacerlo una vez por semana, pero no siempre me acuerdo.

Depués de esta pequeña chapa, y haciendo referencia a los cambios que has realizado en tu sistema, las opciones que barajo son:

– Dejar de almacenar todo el contenido en el NAS y que cada equipo tenga sus propios archivos. Esto implicaría qué el NAS podría ser un destino para los backups de los archivos, y a su vez BackBlaze un segundo destino (no cómo lo tengo ahora).

– Disponer de un NAS más simple, únicamente destinado a backup del NAS principal.

P.D.: se puede configurar duplicati para que envíe alertas al email. En este enlace (https://forum.duplicati.com/t/how-to-configure-automatic-email-notifications-via-gmail-for-every-backup-job/869) está bien explicado.

P.D.2: sería interesante un artículo «continuación» en el que expongas cómo has configurado el sistema de comprobación.

Hola tzinm,

Lo primero, gracias por una respuesta tan elaborada. El esquema que tienes ahora mismo se suele usar en el ámbito empresarial donde interesa controlar el acceso y almacenamiento de los documentos para que nada se pierda, y donde los documentos deben ser compartidos entre varios usuarios.

En ámbito doméstico, salvo que queráis compartir archivos entre varias máquinas, creo que es mejor devolver la responsabilidad de almacenamiento a las propias máquinas. En ese caso, podrías configurar el sistema de copias tal y como lo tengo yo ahora: primera copia al NAS (físicamente cercana, barata, rápida de restaurar), y segunda copia a B2 (lejana, de pago, más lenta de restaurar, último recurso).

Sólo recurriría a un segundo NAS (que puede ser una Raspberry Pi 4 con un HDD externo USB 3.0) en caso de que te interese poder acceder a todos los archivos desde cualquier máquina.

Miraré cómo configurar las alertas por email. ¡Gracias por el enlace! Y respecto al sistema de comprobación, aún no puedo contarlo porque aún no lo he diseñado. Lo tengo en mi larga lista de asuntos pendientes. Espero que no se quede en el tintero demasiado tiempo.

Un saludo.

Hola de nuevo!

Nada que agradecer :-). Sí, es cierto, es el uso habitual en empresas cuando es necesario disponer de ciertos archivos de forma centralizada. En mi caso, lo he mantenido hasta ahora porque accedía desde dos equipos de indistintamente y además muy amenudo.

Hace algún tiempo que probé alguna herramienta para evitar tener que centralizar todos los archivos, y solamente disponer de aquellos que sí que necesitaba que estuviesen accesibles en todos los equipos en todo momento. Probé Syncthing y funciona de maravilla, el único «inconveniente» es que pierdo espacio por tener, esos archivos que se encuentra sincronizados, «duplicados».

Como te decía en mi anterior comentario y aprovechando que tengo que actualizar el SO del NAS a la última versión, creo que es buen momento para estudiar cuál es la mejor opción que se adapta a mis necesidades, que creo que no es la estructura que tengo actualmente.

Gracias a ti por el artículo y viendo que publicas temas de mi interés (aunque no lo hagas muy a menudo), feed que me guardo.

P.D.: me he demorado en la respuestas porque no me ha llegado ninguna notificación a mi email, ni de tu respuesta ni de la petición habitual que envía WordPress para la suscripción a una entrada en la que has comentado.

Saludos!

Century to a kind of destruction:

Source my dogecoin info

Puedes hacer que envíe una notificación cada vez que ejecutas un backup, o con algun evento. El código has de ponerlo en el aptdo > Configuraciones y picas abajo a la derecha «editar como texto».

Luego introduces:

–send-mail-any-operation=true

–send-mail-body=%RESULT%

–send-mail-level=Warning,Error,Fatal

–send-mail-subject=Informe de la tarea %backup-name% en Nombre-del-PC

–send-mail-to=email-donde-recibir-la-notificacion

–send-http-result-output-format=Duplicati

–send-mail-url=smtp://mail.tu-servidor.com:25/?starttls=when-available

–send-mail-username=email-desde-donde-se-envia-la-notificacion

–send-mail-password=su-comtraseña

–send-mail-from=email-desde-donde-se-envia-la-notificacion

Para finalizar, pulsar OK y listo. Ahora recibirás un email con el informe, cuando haya una advertencia, u error o fallo fatal.

handwritten books were made,